Conventions de transcription

Un nouveau manuel de transcription concernant les interactions multimodales dans Second Life est disponible ici : Saddour I., Wigham C., Chanier T. (2011) Manuel de transcription de données multimodales dans Second Life http://edutice.archives-ouvertes.fr...

Dans le projet Mulce, la question de la transcription des corpus se pose d’une manière complexe en raison de la nature des données multimodales. Les informations accessibles dans les données primaires sont représentées sous forme de notations textuelles, rendant compte de la temporalité des phénomènes. Cette opération renvoie à différents principes et conventions permettant les requêtes automatisées à partir de la transcription alignée avec le signal audio/vidéo.

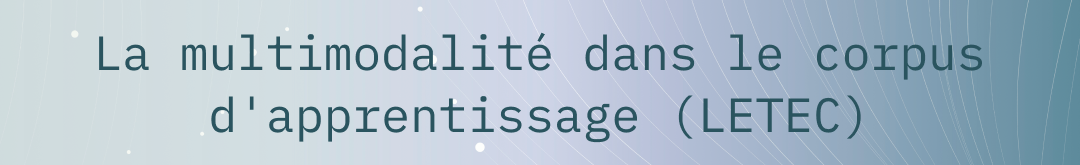

Les conventions de transcription adoptées induisent le niveau du grain d’analyse. Afin de rendre compte des actions dans des situations collectives, il faut être capable de caractériser pour chaque action, outre sa signification : qui la réalise, qui peut la voir, et donc où et quand elle a lieu. Pour cela, au delà de la différenciation des groupes, l’unité première de « découpage » des enregistrements vidéo est la notion de session.

Ensuite chaque session est composée d’espace-temps qui caractérisent le lieu et la date/heure d’une action. Nous avons défini la notion d’espace-temps ET = (S, t0, t1) comme un lieu S (salle ou espace virtuel) où un groupe se retrouve effectivement dans un intervalle de temps [t0, t1] avec t0 : la date d’entrée de la première personne dans l’espace et t1 : la date de sortie de la dernière personne de cet espace. Cette notion permet de regrouper les actions ayant eu lieu dans un même espace-temps, c’est à dire, en général, partagées par un groupe de personnes identifiées. Dans l’environnement audio-graphique synchrone du corpus Copéas, cette notion est indispensable car des actions ayant lieu dans un espace à un instant donné, ne sont pas lisibles/audibles par les personnes se trouvant au même moment dans un espace différent. Nous avons, en parallèle, divisé chaque session en séquences pédagogiques. Ce découpage identifie de manière plus précise mais subjective les grandes activités d’une session par exemple : salutations, présentation des consignes, travail en sous-groupes, restitution du travail, débriefing, bilan.

Nous proposons donc deux points de vue, l’un pédagogique et l’autre plus objectif, pour une transcription de la co-présence d’acteurs dans un lieu et durant une période donnée.

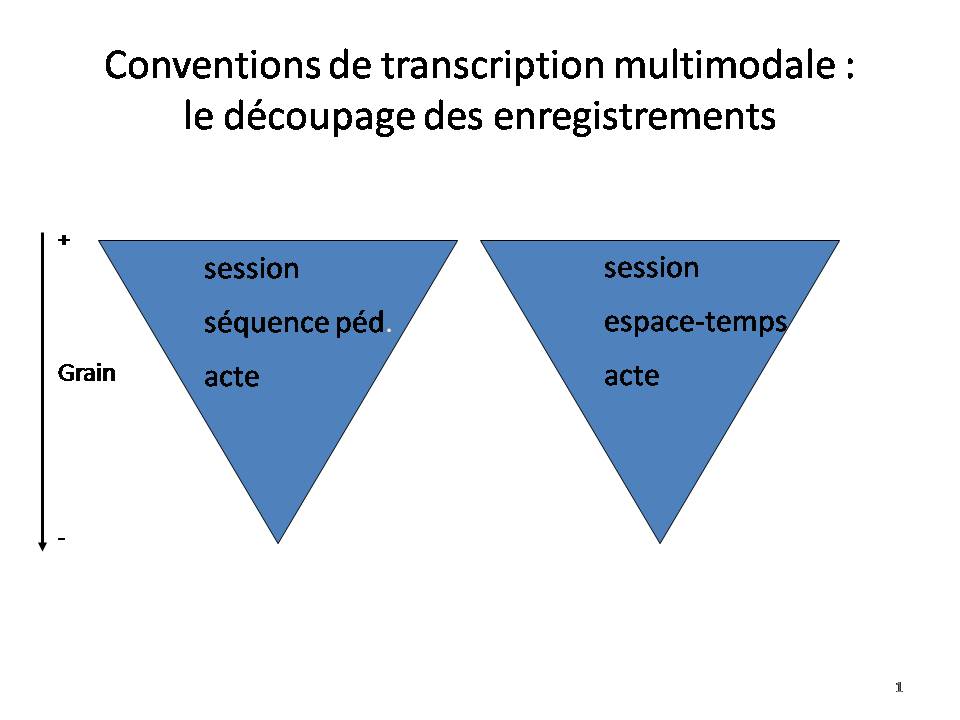

Par ailleurs, s’agissant de transcriptions multimodales, chaque acte est caractérisé systématiquement par une modalité (audio, vote, clavardage, module de production, etc.), une valeur (ce qui a été dit, écrit ou fait), une date de début et éventuellement une date de fin, l’acteur ayant réalisé cet acte, l’espace-temps dans lequel il a eu lieu et la séquence à laquelle il est rattaché. Les tours de parole audio et les actions de production ont des attributs supplémentaires permettant d’affiner la description de leur réalisation dans ces modes spécifiques.

Concernant la parole, les caractéristiques de l’oral telles qu’elles apparaissent dans l’environnement audio synchrone sont fortement conditionnées par la représentation de l’oral des concepteurs de la plate-forme. Ainsi, des boutons et icônes en rapport permettant aux acteurs

de communiquer à plusieurs à distance, pour éviter sans l’interdire le chevauchement qui rend la communication difficile. Les acteurs peuvent ainsi, comme nous l’avons demander la parole, indiquer qu’ils parlent, acquiescer ou refuser par les boutons de vote assurant ainsi la bonne qualité de la communication(Lamy, 2006), (Hampel, 2006). Ces différents éléments donnent lieu à un codage dans la transcription. Au besoin quelques éléments de phonétique ont été transcrits, notamment lorsque la prononciation a joué un rôle dans l’interprétation du message, cette transcription phonétique n’étant donc pas systématique. Nous avons également choisi de coder les silences pour pouvoir les quantifier ou savoir qui reprend la parole après une longue pause. Ainsi dès qu’un silence excède 3 secondes, il est alors considéré comme un tour de parole à part entière attribué à l’"acteur" silence, afin de pouvoir lui donner une place à part entière dans la distribution des tours de parole. Les recouvrements sont finalement peu présents à l’audio et sont majoritairement multimodaux (par exemple un acteur intervient dans le clavardage pendant qu’un autre parle). La date/heure des actions permet cependant de rendre compte du chevauchement entre les actions.

Enfin, concernant des actions effectuées dans un module de production collaborative nous n’avions pas de cadre scientifique pour les transcrire. La difficulté principale pour ce type de transcription est de définir le grain de caractérisation de l’action. Par exemple pour un module de traitement de texte quel est l’objet ou l’unité manipulé : l’ensemble du texte, le paragraphe, la ligne le mot ou le caractère ? Tout dépend de l’analyse qu’on veut faire par la suite et de l’utilisation de la transcription. Dans notre cas, l’utilisation de la vidéo permet d’analyser très finement les actions effectuées, les transcriptions n’ont donc pas pour objectif de représenter l’action au niveau le plus fin possible.

A titre d’exemple, voici les choix que nous avons effectués pour le travail dans les collecticiels :![]() pour le traitement de texte, nous avons utilisé comme objet la notion de paragraphe de l’environnement audio synchrone correspondant à une ou deux lignes ;

pour le traitement de texte, nous avons utilisé comme objet la notion de paragraphe de l’environnement audio synchrone correspondant à une ou deux lignes ;

![]() pour le module de carte conceptuelle, les types d’objets manipulables sont le concept et la relation,

pour le module de carte conceptuelle, les types d’objets manipulables sont le concept et la relation,

![]() pour le tableau blanc, le trait, la zone de texte, l’ellipse et la punaise.

pour le tableau blanc, le trait, la zone de texte, l’ellipse et la punaise.

La valeur de l’action correspond à une des quatre activités suivantes : créer, éditer, supprimer ou sélectionner.

![]() conventions de transcriptions simplifiées utilisées dans le projet Infral (interculturel France-Allemagne), avec plate-forme audio-synchrone Centra.

conventions de transcriptions simplifiées utilisées dans le projet Infral (interculturel France-Allemagne), avec plate-forme audio-synchrone Centra.

![]() conventions complètes utilisées dans le LETEC Copéas, avec plate-forme audio-synchrone Lyceum.

conventions complètes utilisées dans le LETEC Copéas, avec plate-forme audio-synchrone Lyceum.

La multimodalité dans les environnements audiographiques synchrones

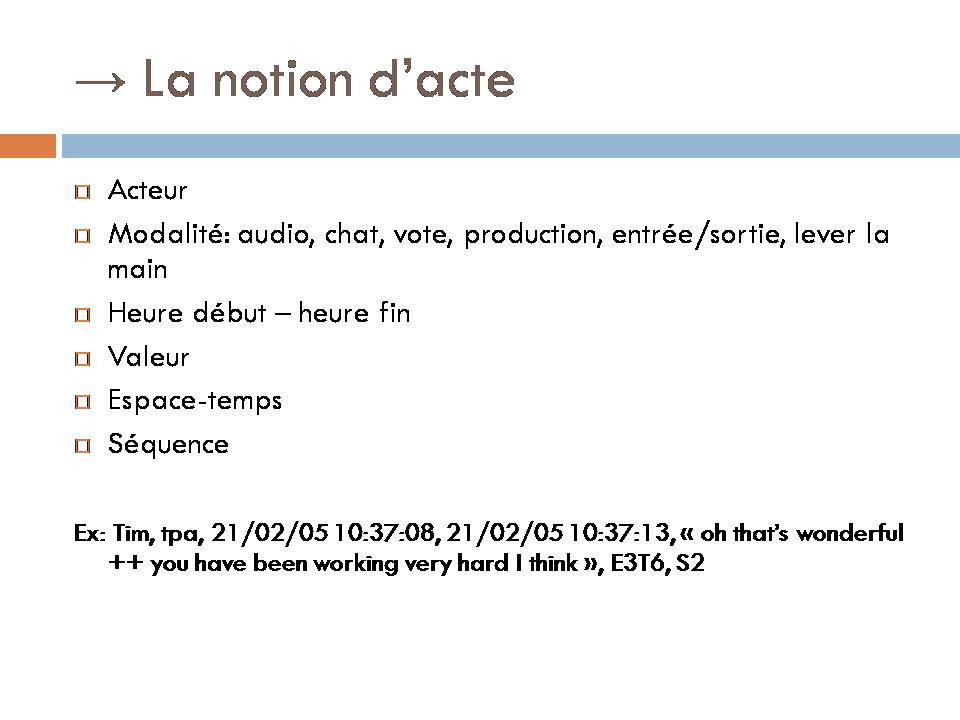

Les environnements informatiques intégrant la multimodalité permettent aux acteurs de recourir à une variété de modes pour communiquer : les modes textuel, parole, graphique, iconique, auxquels s’ajoute un mode spatial qui correspond à la localisation et au déplacement des participants dans les différentes salles et modules de la plateforme.

À chaque mode communicationnel correspond une modalité, c’est-à-dire une forme concrète particulière de communication. Par exemple, dans les environnements audiographiques synchrones (AGSE) étudiés dans les corpus composant le projet Mulce, nous repérons la corrélation suivante :

![]() Le mode Textuel renvoie aux modalités clavardage, traitement de texte, carte conceptuelle, tableau blanc

Le mode Textuel renvoie aux modalités clavardage, traitement de texte, carte conceptuelle, tableau blanc![]() Le mode Parole renvoie à la modalité Audio

Le mode Parole renvoie à la modalité Audio![]() Le mode Graphique renvoie aux modalités Carte conceptuelle, tableau blanc

Le mode Graphique renvoie aux modalités Carte conceptuelle, tableau blanc![]() Le mode Iconique renvoie aux modalités Vote, entrée/sortie, absence momentanée, main levée, prise de parole

Le mode Iconique renvoie aux modalités Vote, entrée/sortie, absence momentanée, main levée, prise de parole![]() Le mode Spatial renvoie à la modalité Localisation (salle + module)

Le mode Spatial renvoie à la modalité Localisation (salle + module)

A un mode peut correspondre une variété de modalités, comme par exemple dans le cas du mode textuel qui apparaît dans la modalité clavardage, la modalité traitement de texte, la modalité carte conceptuelle ou encore tableau blanc. A certains modes peut ne correspondre qu’une seule modalité, comme dans le cas du mode parole qui ne correspond qu’à la modalité audio. Nous parlerons de communication multimodale quand elle fait intervenir plusieurs modes, ou quand plusieurs modalités sont associées à un seul mode.

En outre, la multimodalité est présente à plusieurs niveaux dans un corpus d’apprentissage :

![]() Les données résultats d’une formation peuvent être de nature textuelle, orale/audio, graphique, iconique, etc. Cette diversité provient des différents modes de communication et de production (écrit, audio, dessin, vote, etc.) que des environnements informatiques intégrant la multimodalité mettent à disposition des apprenants pour communiquer (Reffay & Betbeder, 2006).

Les données résultats d’une formation peuvent être de nature textuelle, orale/audio, graphique, iconique, etc. Cette diversité provient des différents modes de communication et de production (écrit, audio, dessin, vote, etc.) que des environnements informatiques intégrant la multimodalité mettent à disposition des apprenants pour communiquer (Reffay & Betbeder, 2006).

![]() Les données provenant du dispositif de recherche peuvent se présenter sous forme de vidéogrammes dont il faudra ensuite extraire les différentes modalités présentes en particulier dans les environnements synchrones.

Les données provenant du dispositif de recherche peuvent se présenter sous forme de vidéogrammes dont il faudra ensuite extraire les différentes modalités présentes en particulier dans les environnements synchrones.

Les premières étapes de la recherche consistent à annoter et retranscrire ces données avant de se livrer à des analyses multiples (pour avoir une idée de cette variété, voir par exemple (Herring, 2004) et sa recension des perspectives d’analyses de la notion de communauté en ligne).

C’est pourquoi, dans le cadre du projet Mulce, on s’intéresse à l’élaboration à la fois de modèles permettant d’intégrer les différents niveaux de description (Salmon-Alt, Romary & Pierrel, 2004) et également des outils, modèles et procédures aidant à produire ces descriptions (Kress & Jewitt, 2001 ; Avouris & al., 2004 ; Levine & Scollon, 2004 ; Baldry & Tibault, 2006 par exemple).

![]() Betbeder, M.-L., Ciekanski, M., Greffier, F., Reffay, C. & Chanier, T (2008). Interactions multimodales synchrones issues de formations en ligne : problématiques, méthodologie et analyses. In Basque, J. & Reffay, C. (dir.), numéro spécial EPAL (échanger pour apprendre en ligne), Sciences et Technologies de l’Information et de la Communication pour l’Education et la Formation (STICEF), vol. 15, (->http://sticef.univ-lemans.fr/num/vol2008/06-betbeder/sticef_2008_betbeder_06p.pdf]

Betbeder, M.-L., Ciekanski, M., Greffier, F., Reffay, C. & Chanier, T (2008). Interactions multimodales synchrones issues de formations en ligne : problématiques, méthodologie et analyses. In Basque, J. & Reffay, C. (dir.), numéro spécial EPAL (échanger pour apprendre en ligne), Sciences et Technologies de l’Information et de la Communication pour l’Education et la Formation (STICEF), vol. 15, (->http://sticef.univ-lemans.fr/num/vol2008/06-betbeder/sticef_2008_betbeder_06p.pdf] ![]() Chanier, T. & Vetter, A. (2006). "Multimodalité et expression en langue étrangère dans une plate-forme audio-synchrone". Apprentissage des langues et Système d’Information et de Communication (Alsic), vol. 9. http://alsic.revues.org/index270.html

Chanier, T. & Vetter, A. (2006). "Multimodalité et expression en langue étrangère dans une plate-forme audio-synchrone". Apprentissage des langues et Système d’Information et de Communication (Alsic), vol. 9. http://alsic.revues.org/index270.html![]() Ciekanski, M., Chanier, T (2008). Developing online multimodal verbal communication to enhance the writing process in an audio-graphic conferencing environment. Recall, vol. 20 (2), Cambridge University Press. 162-182. doi:10.1017/S0958344008000426 http://edutice.archives-ouvertes.fr...

Ciekanski, M., Chanier, T (2008). Developing online multimodal verbal communication to enhance the writing process in an audio-graphic conferencing environment. Recall, vol. 20 (2), Cambridge University Press. 162-182. doi:10.1017/S0958344008000426 http://edutice.archives-ouvertes.fr...